RSS 2016研讨会随想:质疑者是正确的吗——深度学习在机器人领域的局限和潜力都在哪里?...

本文共 3207 字,大约阅读时间需要 10 分钟。

备注:本文于2016年6月23日发表于(20%为翻译,80%为自己的理解),这里仅作备份用。

导语:RSS(Robotics: Science and Systems,机器人:科学与系统) 是机器人领域的世界顶级学术会议。 John McCormac是伦敦帝国学院戴森机器人实验室(Dyson Robotics Lab at Imperial)的一名博士生,师从Andy Davison教授和Stefan Leutenegger博士。2016年6月,McCormac参加了在密歇根大学召开的RSS 2016大会,他在博客中分享参会的一些心得体会,以下为McCormac博客中的部分编译内容,读者朋友可。

在过去几年里,深度学习技术,在计算机视觉等诸多领域,带来了天翻地覆的变革。在目标识别和检测、场景分类、动作识别等分支,深度学习都有着“惊艳”地成功应用。尽管那边已经“热火朝天”,但在机器人视觉研究这边,深度学习的应用,才刚刚拉开舞台的幕布。

目前,深度学习已经开始在机器人领域“牛刀小试”。例如,在视觉引导机器人的抓取和操纵研究上,就有了成功的应用。

图片来源:谷歌深度思维团队Raia Hadsell在RSS 2016报告幻灯片

但即便如此,深度学习,仍然没有发展成为机器人领域的主流方法。这是因为,有许多著名的机器人、人工智能等领域的专家,直言不讳他们的质疑和顾虑,他们不相信深度学习能在不同的机器人应用场景中,得到普及使用,并质疑深度学习驱动下的机器人安全性能。

质疑者在哪里?

整体来说, 研讨会很有意思。在研讨会快结束的时候,主持人Pieter Abbeel(斯坦福大学副教授)问道,现场有多少的观众,对深度学习在机器人领域的应用,秉持怀疑态度,150~200的观众席中,仅有5~10名观众举手表示质疑。

即使身处质疑者的阵营,他们的立场也并非坚定如铁,因为在被问到为啥质疑时,他们表态说,作为机器人研究的一个辅助工具,深度学习还是有用武之地的。

质疑者的疑虑,并非空穴来风,这些疑虑主要来自两个方面,一是在特定场景下,机器人的行为难以确保。比如说,自动驾驶机器人,在遇到险情时,是保护车上的主人——司机,还是要保护路上的行人?

二是深度学习的可解释性。深度学习在某些领域的应用效果极佳,可是为什么极佳,深度学习的应用者们,目前为止,也未能给出合理的解释。

针对第一点疑虑,著名未来学家Kevin Kelly(昵称KK)在《失控》一书中给出了一点解释。KK预言未来的世界,有两个特征:(1) 自然生命体的机械化;(2) 人造生命体的生物化。对于类似与机器人的人造生命体,KK非常乐观地告诉我们,不必担心:作为造物者,我们要对人造生命体负责,让他们遵循机器人三定律就好。(你信KK所言吗?你不疑虑吗?)

质疑阵营和拥护阵营之间,并非泾渭分明。时间流逝掉得不仅仅是岁月,还有观念的淡化或转化。下面说的就是一个有关质疑者的故事——Larry Jackel(著名人工智能专家、North C .科技公司主席)曾经参与了一个关于神经网络未来的著名赌局。

一场有关神经网络的著名赌局

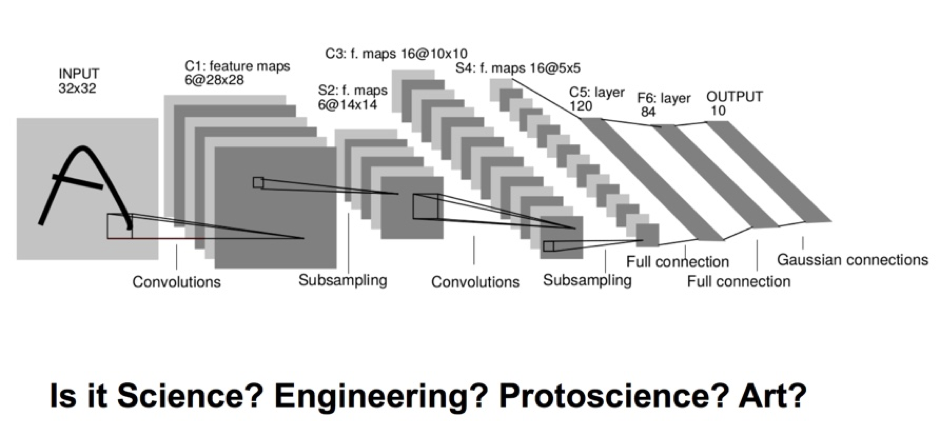

我们知道,卷积神经网络是深度学习最重要的分支之一。“卷积”和“深度”是神经网络互相独立的两个性质。“卷积”指的是前端有卷积层;“深度”指的是除了卷积层之外还有很多层。现在看来,深度学习在很多领域都是风生水起,大放异彩。但这仅仅是“看见贼吃肉,没见贼挨揍”。

虽然大部分人的感觉,深度学习是最近几年才迅速崛起的,但深度学习的基础理论——人工神经网络,早在上个世纪八十年代,就有了一定的发展,后期遭遇瓶颈,进入漫长的“冬眠期”。其中卷积神经网络在刚面世时,就受到了很多人的质疑,Vladinmir Vapnik就是众多质疑者的一个。Vapnik是何许人也?此君来头不小。他不仅是一名出色的数学家,而且还是目前应用最广的人工智能模式之一——支持向量机(SVM)之父。

那时(1995年),Jackel认为,到2000年,人们能够明确了解人工神经网络能够发挥多大作用。

Vapnik并不认可这个观点。他认为,别说1995了,就算到2005年,也就是十年后,任何思维正常的人,都不会知道神经网络有啥用,怎么用。

1995年3月,在谁也不能说服谁的情况下,二人决定打赌定输赢。赌注是一顿奢华晚餐。

双方在证人面前签字画押,Yann LeCun是第三方签名人(Yann LeCun ,目前炙手可热的人工智能专家,Facebook人工智能实验室主任,纽约大学数据科学中心创始人,当年由 Jackel招进贝尔实验室)。

一开始,Vapnik赢了,因为到了2000年,神经网络的内部工作原理,基本上仍然被神秘所笼罩,研究人员无法明确地判断出,如何让神经网络更好地应用在现实生活之中。

但Vapnik猜到了前头,却没有猜到后头。

在2005年左右(更确切地说是2006年),加拿大多伦多大学教授、机器学习领域的泰斗Hinton教授和他的学生Salakhutdinov在顶尖学术刊物《科学》上发表了一篇文章,开启了深度学习在学术界和工业界的“拓疆扩土”的浪潮。这篇文章提供了两个核心信息:(1)很多隐层的人工神经网络具有优异的特征学习能力,学习得到的特征对数据有更本质的刻划,从而有利于可视化或分类;(2)深度神经网络在训练上的难度,可以通过“逐层初始化”(Layer-wise pre-training)来有效克服,可在海量数据上展开并行神经网络的参数训练。

现在的局面,大家看到了。在很多领域中,深度学习(卷积神经网络)得到非常广泛而深入的应用。如果Jackel已经兑现了自己的赌注,那么现在的Vapnik,似乎应该回请Jackel两顿奢华晚餐,作为补偿。在现实面前,如果Vapnik不固执己见,那么这名先前的质疑者,是时候转变自己的观点了。

虽然深度学习有了比较广泛的应用,但质疑并没有结束。

比如说,深度学习这项技术虽然很强大,但为啥这么强大?即使是深度学习的领域专家,也不能给出令人信服的理由。也就是说,深度学习的内部工作原理,仍然是云罩雾绕,仍然是个有待破解的谜。

因此,也有人说,深度学习压根就不是什么科学嘛,仅仅是一个工程而已。如同那句人工智能的调侃:“有多少人工,就有多少智能”。深度学习的调参,何尝不是一个体力活?

图片来源:Oliver Brock在RSS 2016报告幻灯片(Oliver Brock为德国柏林大学 机器人与生物实验室研究员)

如果深度学习内部的机理都弄不清楚,就把这套理论应用在更贴近人们生活中的机器人上,这靠谱吗?安全性又如何保证?人们不能不疑虑重重啊!

沉默的大多数

在这次研讨会上,表面上看来,现场表示质疑的人,比例较小(5/150左右),但实际上,这个比例可能要大得多,因为有些观众即使身处“质疑者”阵营,也不会轻易公开发声。所以,不论是问卷调查也好,还是举手表决也罢,不要认为,在这类场景下,就一定能够把大多数人的真实意思表达出来。

之所以这么说,是有其理论依据的。早在1974年,德国社会学家伊丽莎白•诺尔-诺依曼(Elisabeth Noelle-Neumann)就在其名著《沉默的螺旋》(The Spiral Of Silence)中 ,就表达了类似的观点:大多数个人会力图避免由于单独持有某些态度和信念而产生的孤立。因为害怕孤立,他便不太愿意把自己的观点说出来。因此,当发觉自己的某一观点无人或很少有人理会(有时会有群起而攻之的遭遇),即使自己赞同它,也会保持沉默。意见一方的沉默,造成另一方意见的增势,如此循环往复,便形成了一方的声音越来越强大,从而形成“沉默的大多数”,而另一方越来越沉默下去的螺旋发展过程。

质疑还在继续,他们是正确的吗?让时间给出答案吧。

译者介绍:张玉宏,著有一书。

转载地址:http://tofnx.baihongyu.com/

你可能感兴趣的文章

linux 帮助命令

查看>>

Google Code Jam 2015 R1C B

查看>>

[开源]KJFramework.Message 高性能二进制消息框架-非托管优化

查看>>

iostream与iostream.h的区别

查看>>

JS实现简易图片轮播效果的方法

查看>>

树形DP+DFS序+树状数组 HDOJ 5293 Tree chain problem(树链问题)

查看>>

GDB调试

查看>>

Spring+MyBatis多数据源配置实现

查看>>

Java微信公众平台开发(十三)--微信JSSDK中Config配置

查看>>

关于烂代码的那些事(上)

查看>>

CTF-i春秋网鼎杯第四场部分writeup

查看>>

[NIOS] 如何Erase EPCS flash內容

查看>>

Oracle EBS-SQL (QA-3):检查已检验未入库.sql

查看>>

设计模式学习,总结于一位博友

查看>>

元类metaclass

查看>>

Android学习笔记-----------布局(四)

查看>>

面向对象第二次博客

查看>>

HDU-1845-Jimmy's Assignment

查看>>

Nexus Maven 私服搭建

查看>>

WIN32界面开发之三:DUI雏形开发(一)

查看>>